Allen's 데이터 맛집

심층신경망(DNN) 이란? 본문

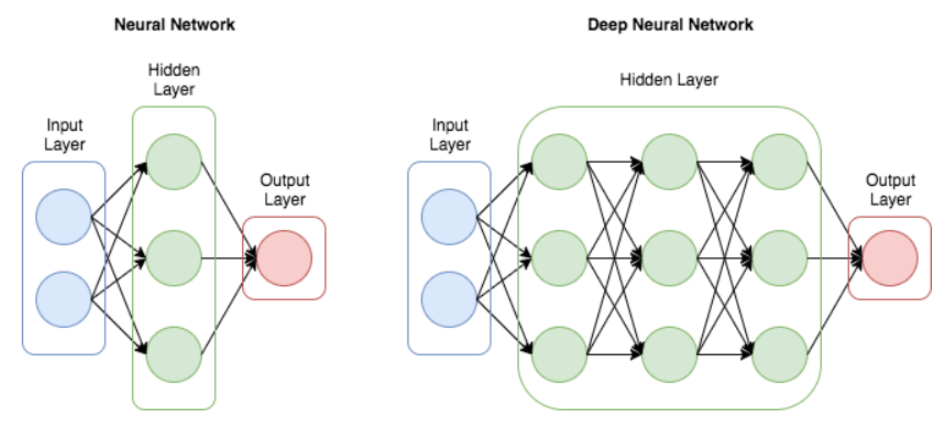

오늘은 머신러닝에서 중요한 역할을 하는 심층신경망(Deep Neural Network, DNN)에 대해 알아보겠습니다. 심층신경망은 다층 퍼셉트론을 확장한 개념으로, 복잡한 데이터 패턴을 학습하고 예측하는 데 탁월한 성능을 발휘합니다

이미지출처:https://hong-zone17.tistory.com/76

심층신경망(DNN)이란 무엇인가요?

심층신경망은 여러 개의 은닉층(hidden layer)을 가진 신경망입니다. 기본적인 인공신경망(Artificial Neural Network, ANN)은 입력층(input layer), 출력층(output layer), 하나의 은닉층으로 구성되지만, DNN은 이 은닉층을 여러 개 쌓아 올림으로써 더욱 복잡한 데이터 패턴을 학습할 수 있습니다.

DNN의 구성 요소

1. 입력층(Input Layer): 모델에 입력되는 데이터가 위치하는 층입니다.

2. 은닉층(Hidden Layer): 입력 데이터를 처리하고 특징을 추출하는 층입니다. DNN에서는 이 층이 여러 개 쌓여 있습니다.

3. 출력층(Output Layer): 최종 예측 결과를 출력하는 층입니다.

심층신경망의 동작 원리

DNN은 기본적으로 퍼셉트론(Perceptron)의 개념을 확장한 것입니다. 각 노드는 입력 신호를 받아 가중치(weight)를 곱한 후 활성화 함수(activation function)를 통해 출력 신호를 생성합니다. 여러 층을 거치면서 데이터의 복잡한 패턴을 학습하게 됩니다.

활성화 함수

활성화 함수는 뉴런의 출력 값을 결정하는 함수입니다. DNN에서 자주 사용되는 활성화 함수는 다음과 같습니다:

- ReLU(Rectified Linear Unit): 가장 많이 사용되는 활성화 함수로, 입력 값이 양수일 경우 그대로 출력하고 음수일 경우 0을 출력합니다.

ReLU(x) = max(0,x)

- Sigmoid: 출력 값을 0과 1 사이로 압축하는 함수로, 주로 이진 분류 문제에서 사용됩니다.

σ(x) = 1 / 1+e −x1

- Tanh: 출력 값을 -1과 1 사이로 압축하는 함수로, 출력 값의 중심을 0으로 만듭니다.

tanh(x) = ex + e −x / ex + (e−x)

심층신경망의 학습 과정

DNN의 학습 과정은 크게 순전파(forward propagation)와 역전파(backpropagation)로 이루어집니다.

순전파

입력 데이터를 통해 각 층을 거쳐 출력을 계산하는 과정입니다. 각 층의 뉴런은 이전 층의 출력을 받아 가중치를 곱하고 활성화 함수를 적용하여 다음 층으로 전달합니다.

역전파

출력과 실제 값 사이의 오차를 계산하여 가중치를 업데이트하는 과정입니다. 오차의 기울기를 계산하여 가중치를 조정함으로써 모델의 예측 성능을 개선합니다.

심층신경망의 구현

이제, 심층신경망을 PyTorch를 이용하여 구현해보겠습니다.

import torch

import torch.nn as nn

import torch.optim as optim

# 신경망 모델 정의

class DNN(nn.Module):

def __init__(self):

super(DNN, self).__init__()

self.fc1 = nn.Linear(784, 256)

self.fc2 = nn.Linear(256, 256)

self.fc3 = nn.Linear(256, 10)

self.relu = nn.ReLU()

def forward(self, x):

x = self.relu(self.fc1(x))

x = self.relu(self.fc2(x))

x = self.fc3(x)

return x

# 모델 초기화

model = DNN()

# 손실 함수와 최적화 알고리즘 설정

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 데이터셋 로딩 (예: MNIST)

from torchvision import datasets, transforms

train_dataset = datasets.MNIST(root='./data', train=True, transform=transforms.ToTensor(), download=True)

train_loader = torch.utils.data.DataLoader(dataset=train_dataset, batch_size=64, shuffle=True)

# 모델 학습

for epoch in range(5): # 에포크 수는 예시로 5로 설정

for images, labels in train_loader:

images = images.view(-1, 28*28) # 이미지를 1차원 텐서로 변환

optimizer.zero_grad()

outputs = model(images)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

print(f'Epoch [{epoch+1}/5], Loss: {loss.item():.4f}')

심층신경망의 응용 사례

1. 이미지 인식

심층신경망은 이미지 인식에서 뛰어난 성능을 발휘합니다. 예를 들어, Convolutional Neural Network(CNN)는 이미지 데이터를 처리하는 데 최적화된 구조를 가지고 있습니다.

2. 자연어 처리

자연어 처리(NLP)에서도 심층신경망이 널리 사용됩니다. Recurrent Neural Network(RNN)과 Transformer 모델은 텍스트 데이터를 처리하는 데 효과적입니다.

3. 자율주행

자율주행 기술에서는 심층신경망을 이용해 도로 상황을 인식하고 주행 경로를 결정합니다.

4. 음성 인식

심층신경망은 음성 인식에서도 중요한 역할을 합니다. 음성 데이터를 텍스트로 변환하는 데 사용됩니다.

심층신경망의 장단점

장점

- 복잡한 패턴 학습: 여러 은닉층을 통해 복잡한 데이터 패턴을 학습할 수 있습니다.

- 다양한 응용 분야: 이미지, 텍스트, 음성 등 다양한 데이터 유형에 적용 가능합니다.

- 높은 성능: 적절한 데이터와 하드웨어 지원을 받으면 매우 높은 성능을 발휘할 수 있습니다.

단점

- 학습 시간: 많은 데이터와 연산을 필요로 하여 학습 시간이 오래 걸릴 수 있습니다.

- 과적합: 모델이 너무 복잡해지면 과적합이 발생할 수 있습니다. 이를 방지하기 위해 드롭아웃(Dropout)과 같은 정규화 기법이 필요합니다.

- 해석의 어려움: 모델이 복잡할수록 그 내부 동작을 해석하기 어려워질 수 있습니다.

해시태그

#심층신경망 #DNN #딥러닝 #인공지능 #AI #기계학습 #머신러닝 #신경망 #데이터분석 #PyTorch